AI bots zorgden voor overlast en zijn geblokkeerd

Geschreven op 30-09-2024 door Sander CruimingCategorieën: Online Beveiliging

De afgelopen drie tot vier weken merkten we dat steeds meer websites van onze klanten trager of zelfs onbereikbaar werden, zonder dat wij of de klant noemenswaardige wijzigingen hadden doorgevoerd. Het bleek dat deze websites tot soms wel duizenden aanvragen per uur kregen van zogenoemde AI bots. We hebben daar maatregelen tegen genomen. In deze blogpost kun je hier meer over lezen.

Wat zijn AI bots?

AI bots zijn robots die data van een groot aantal websites op het gehele internet verzamelen ("scrapen" genoemd) om een AI model van informatie te voorzien en dit model te trainen. Bekende AI modellen zijn bijvoorbeeld ChatGPT van OpenAI en Claude van Anthropic. Er zijn tientallen andere van dit soort AI bots actief op het internet.

Hoe zorgen deze AI bots voor overlast?

Het probleem met de AI bots is dat een bot een website voortdurend ontzettend vaak opvraagt, soms tot wel duizenden keren per uur. Dit kost veel rekenkracht. Verder gebruiken bots vaak dynamische website-elementen zoals formulieren en zoekfuncties, die alleen nog maar meer rekenkracht vergen. Zulke elementen staan namelijk niet in een cache, en gebruiken veel databasecapaciteit.

Dit gebeurde op zo'n grote schaal dat zo'n 40% van de websites die bij ons gehost werden hier hinder van ondervond. Websites werden hierdoor trager of zelfde onbereikbaar; sommige sites zelfs de gehele dag door. De afgelopen dagen zagen we het percentage van websites nog verder oplopen, waardoor we maatregelen moesten nemen.

Welke maatregelen hebben jullie genomen?

Omdat het probleem zo snel groter werd, hebben we besloten om op korte termijn actie te ondernemen. Dat websites voor langere tijd traag en onbereikbaarzijn door deze AI bots vonden we onacceptabel. We hebben daarom de meest agressieve AI bots geblokkeerd. Deze maatregel is in principe tijdelijk, en blijft actief totdat de overlast weer is afgenomen.

De blokkade vindt plaats op basis van de "User Agent" die een bot meestuurt, en zo'n aanvraag wordt dan beantwoord met een "403 Forbidden". Onderaan deze blogpost hebben we de lijst van geblokkeerde AI bots toegevoegd.

We blokkeren liever geen verkeer op deze manier, maar omdat de overlast dusdanige vormen begon aan te nemen, voelden we ons genoodzaakt op deze maatregel nu eerst te nemen.

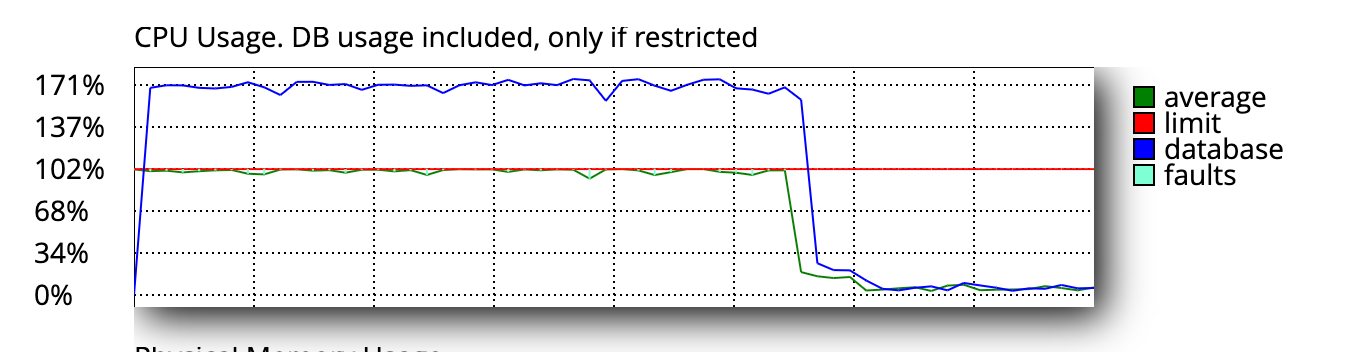

Hieronder kun je een voorbeeld zien van een website waarvan de volledige capaciteit (zowel CPU- en database-rekenkracht) door AI bots werd verbruikt. Deze website was daardoor onbereikbaar. Na het blokkeren van de AI bots, is de rekenkracht terug naar een normaal niveau en werkt de website weer naar behoren.

Wat zijn eventuele nadelige gevolgen?

Het gevolg van het blokkeren van AI bots is dat deze bots geen data meer kunnen verzamelen van websites die bij ons gehost zijn voor het trainen van hun AI modellen. We verwachten dat de impact voor onze klanten klein is; de meeste klanten waren niet op de hoogte dat de data op hun websites hiervoor werd gebruikt en zouden daar waarschijnlijk ook geen toestemming voor hebben gegeven, als dat hen zou worden gevraagd.

Een ander nadelig gevolg is dat als een website gebruik maakt van een AI model, waarbij de website als input/prompt wordt gebruikt. Dit zou dan ook worden geblokkeerd.

Neem contact met ons op via e-mail, mocht je negatieve gevolgen ondervinden n.a.v. deze blokkade. We proberen dan met je mee te denken voor een work-around. Het is helaas - in elk geval op dit moment - niet mogelijk om de blokkade in zijn geheel op te heffen, gezien het aantal websites wat offline ging dusdanig groot was.

Lijst van geblokkeerde AI bots

De AI bots die op dit moment geblokkeerd zijn:

- AhrefsBot

- AI2Bot

- Ai2Bot-Dolma

- Amazonbot

- Applebot

- Applebot-Extended

- Baiduspider

- Bytespider

- CCBot

- ChatGPT-User

- Claude-Web

- ClaudeBot

- Diffbot

- DotBot

- FacebookBot

- FriendlyCrawler

- GPTBot

- Google-Extended

- GoogleOther

- GoogleOther-Image

- GoogleOther-Video

- ICC-Crawler

- ImagesiftBot

- Kangaroo Bot

- Meta-ExternalAgent

- Meta-ExternalFetcher

- MJ12bot

- OAI-SearchBot

- PerplexityBot

- PetalBot

- Scrapy

- SemrushBot

- Sidetrade indexer bot

- Timpibot

- VelenPublicWebCrawler

- Webzio-Extended

- YouBot

- anthropic-ai

- cohere-ai

- facebookexternalhit

- iaskspider/2.0

- img2dataset

- omgili

- omgilibot